반응형

Ⅰ. 단어간 상관관계 집중, 어텐션 매커니즘의 개요

가. 어텐션 매커니즘의 정의

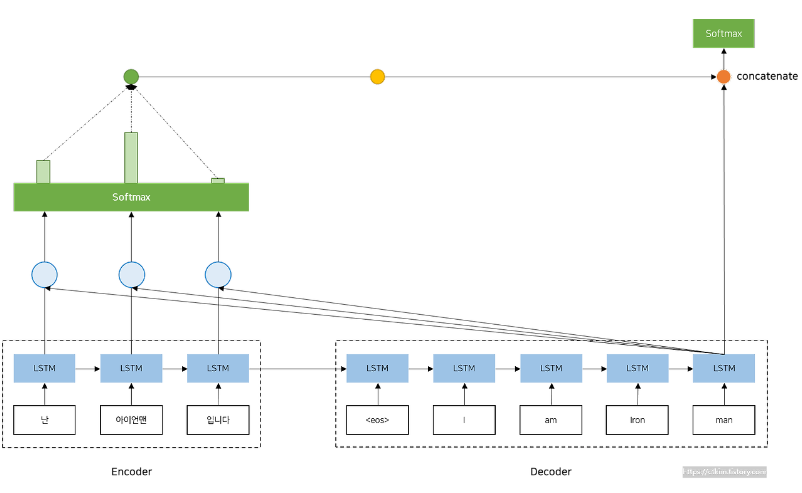

- 언어모델에서 디코더의 출력 단어를 예측하는 매시점에 예측해야 할 단어와 연관이 있는 입력 단어에 좀 더 집중하도록 구조화하는 방법

나 .어텐션 매커니즘 등장 배경

RNN 기반 Seq2seq 모델 문제점

- 하나의 고정된 크기의 벡터에 모든 정보를 압축하여 정보손실 발생

- RNN의 고질적인 문제인 Vanishing Gradient Problem 존재

- 입력 데이터가 길어질때 성능 저하를 보정하기 위한 방법이 어텐션 기법

Ⅱ. 어텐션 매커니즘의 원리와 계산 과정

가. 어텐션 매커니즘의 원리

- Attention Value는 쿼리와 키의 유사도를 구하고 이 유사도를 반영하여 Value(값)에 적용한 값

- Attention Function은 주로 Dot-Product Attention, 즉 내적 연산 주로 사용

나. 어턴션 계산 과정

| 단계 | 과정 | 상세 설명 |

| 1 | Attention Score 계산 | - 쿼리와 키 사이의 유사도 계산 - 쿼리는 디코더의 t시점의 은닉 상태 - 키는 인코더의 모든 시점의 은닉 상태 |

| 2 | Attention Distribution 계산 | - 디코더의 t시점에 인코더의 각 시점의 정보가 얼마나 중요한지 계산 - 소프트맥스 함수 활용 합이 1이되는 확률 분포 계산 |

| 3 | Attention Value 계산 | - 어텐션 가중치와 인코더 값 곱한 후, 모든 인코더 시점에 대해 합산하여 어텐션 값 계산 |

| 4 | Attention Value와 디코더의 은닉상태 연결 | - 어텐션 값과 디코더의 t시점의 은닉상태 연결하여 새로운 입력으로 사용 |

반응형