반응형

Ⅰ. 인공신경망의 개념, 구성요소, 역할

가. 인공신경망의 개념

- 인간두뇌 세포를 모방하여 뉴런들의 상호작용과 경험을 통해 반복학습하는 과정을 모형화하는 분석 기법

나. 인공신경망 구성요소 및 역할

| 구조 | 구성요소 | 역할 |

| input layer | 입력값 | - 모델 학습을 위한 학습 데이터 |

| hidden layer | 가중치 | - 활성화 함수의 입력값으로 사용되는 뉴런간 연결 계수 |

| 활성화 함수 | - 임계값을 이용 뉴런의 활성화 여부를 결정하는 함수 | |

| output layer | 출력값 | - 학습을 통해 도출된 결과값 |

Ⅱ. 피드포워드 뉴럴 네트워크 개념 및 절차

가. 피드포워드 뉴럴 네트워크의 개념

- 인공신경망의 최초의 가장 단순한 형태로 입력층에서 출력층으로 단 방향으로 진행하며 학습하는 모델

나. 피드포워드 뉴럴 네트워크 절차

| 구분 | 절차 |

| 순전파 | 1) 학습 데이터 입력층으로 입력 |

| 2) 은닉층 가중치, 편향 연산 및 활성화 함수 연산 반복 수행 | |

| 3) 연산 결과인 예측값 출력 | |

| 손실 계산 | 4) 예측값과 실제 값 차이 손실 함수 활용 오차 계산 |

| 역전파 | 5) 계산된 오차에 따라 경사 하강법 활용 가중치 갱신 |

| 반복 학습 | 6) 오차 기준 만족할 때까지 전 과정 반복 |

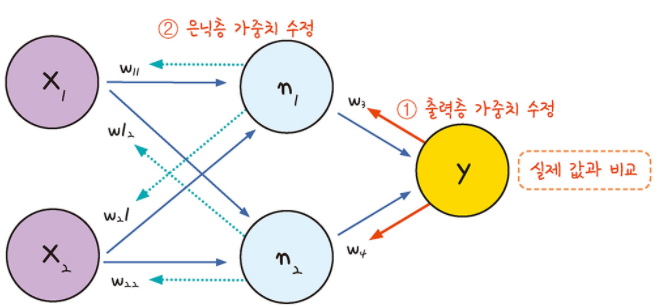

Ⅲ. 역전파 개념 및 절차

가. 역전파의 개념

- 모델의 데이터 예측 결과값으로 실제값과의 오차를 구해 이를 토대로 거슬러 올라가며 가중치를 조정하는 방법

나 .역전파의 절차

| 구분 | 설명 |

| 순전파 | 1) 임의의 초기 가중치 W를 설정한 뒤 학습 데이터를 통해 결과 y_out 계산 |

| 역전파 | 2) 손실 함수를 활용 모델 계산 결과와 실제 값과의 오차 계산 |

| 3) 경사 하강법 이용 이전 가중치를 오차가 작아지는 방향으로 업데이트 | |

| 반복 | 4) 위 과정을 오차가 줄어들지 않을 때까지 반복 |

Ⅳ. 활성화 함수의 종류 및 역할

| 활성화 함수 | 개념도 | 설명 |

| Sigmoid 함수 |  |

- 실수 값을 입력 받아 0과 1 사이 값으로 압축 - 기울기 소멸 문제 발생 가능 |

| Tanh 함수 |  |

- 실수 값을 입력 받아 -1과 1 사이 값으로 압축 - 시그모이드에 비해 최적화를 잘하지만 기울기 소멸 문제 존재 |

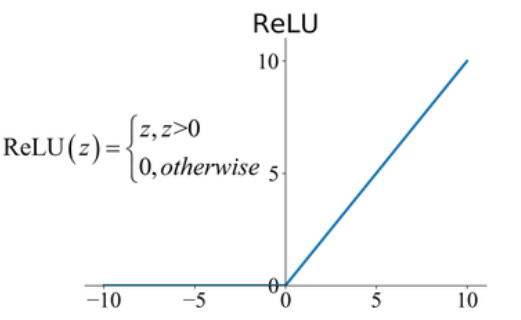

| ReLU 함수 |  |

- 입력값이 0을 넘으로 그대로 출력, 0 이하면 0 출력 - 연산이 빠르고 가장 많이 활용 |

| Leaky ReLU |  |

- ReLU와 유사하지만 입력 값이 0보다 작을 때의 값도 고려 - 깊은 층에서도 손실 없이 정보 전달 |

반응형

'IT 기술 > 인공지능' 카테고리의 다른 글

| 딥페이크 (0) | 2024.10.24 |

|---|---|

| 어텐션 매커니즘 (1) | 2024.10.24 |

| 생성형 인공지능 위험성, 할루시네이션 (1) | 2024.10.11 |

| 하이퍼파라미터 (0) | 2024.10.11 |

| 머신러닝 파이프라인 (1) | 2024.10.11 |