반응형

Ⅰ. 차원의 저주

- 차원이 커질수록 데이터가 Sparse하게 존재하여 학습 데이터의 대표성을 잃고 모델 학습 성능을 저하시키는 현상

Ⅱ. 차원 축소 알고리즘

| 기법 | 개념도 | 설명 |

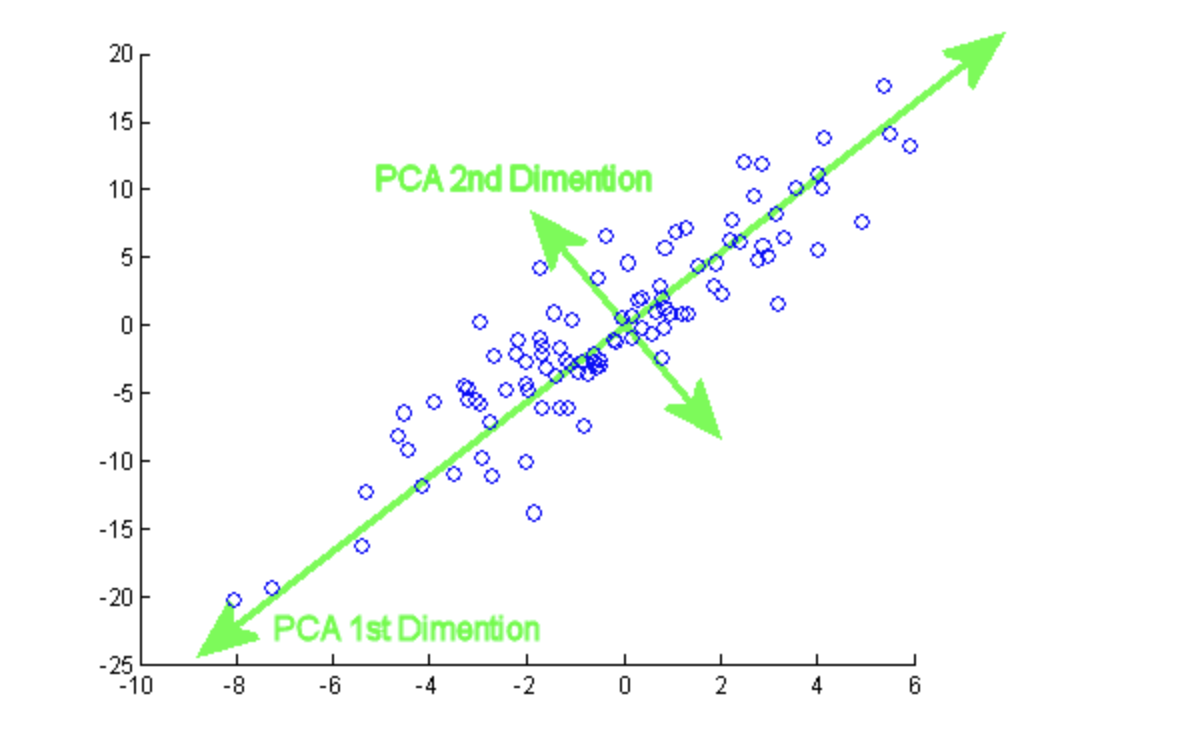

| PCA (Principal Component Analysis) |

|

- 데이터를 축에 사영했을 때 가장 높은 분산을 가지는 데이터의 축을 찾아 그 축으로 차원을 축소 |

| ICA (Independent Component Analysis) |

|

- 다변량의 신호를 통계적으로 독립적인 하부 성분으로 분리하는 계산 방법 - 독립성이 최대가 되는 벡터를 찾는다 |

| LDA (Linear Discriminant Analysis) |

|

- PCA와 다르게 클래스 분류까지 쉽게 할 수 있도록 차원 축소 - 클래스 내부 분산은 작게, 클래스 간 분산은 크게 만들어 내는 축으로 축소 |

| SVD (Singular Value Decomposition) |

|

- 정방행렬이 아닌 행렬도 적용 가능 - 임의의 m x n차원의 행렬 A에 대해 다음과 같이 행렬을 분해하는 방법 A=UΣVT |

반응형

'IT 기술 > 인공지능' 카테고리의 다른 글

| 머신러닝 파이프라인 (1) | 2024.10.11 |

|---|---|

| 인공지능 모델의 성능평가 (0) | 2024.10.11 |

| 머신러닝과 딥러닝 차이 (3) | 2024.10.11 |

| 멀티모달 AI (2) | 2024.10.11 |

| 강화학습 (1) | 2024.10.11 |